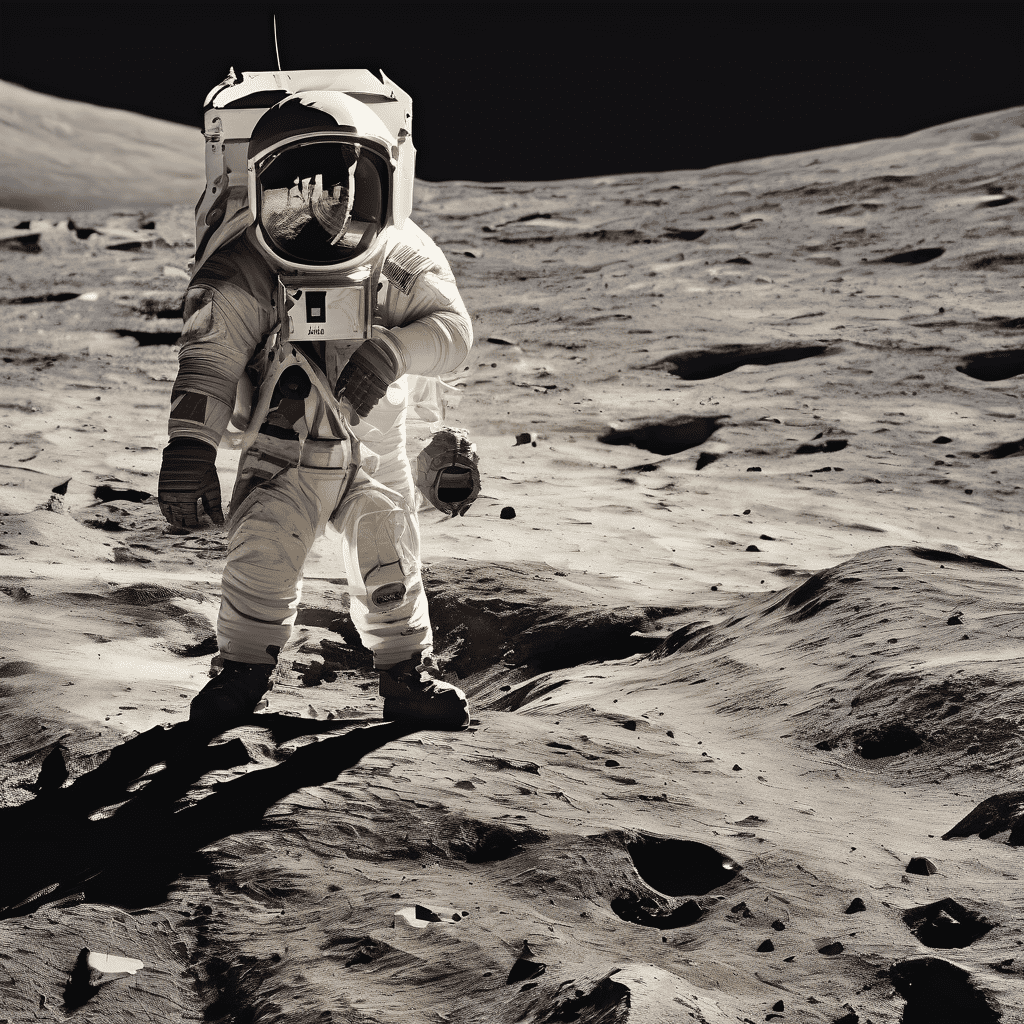

Создание изображений из текста с помощью AI-генератора

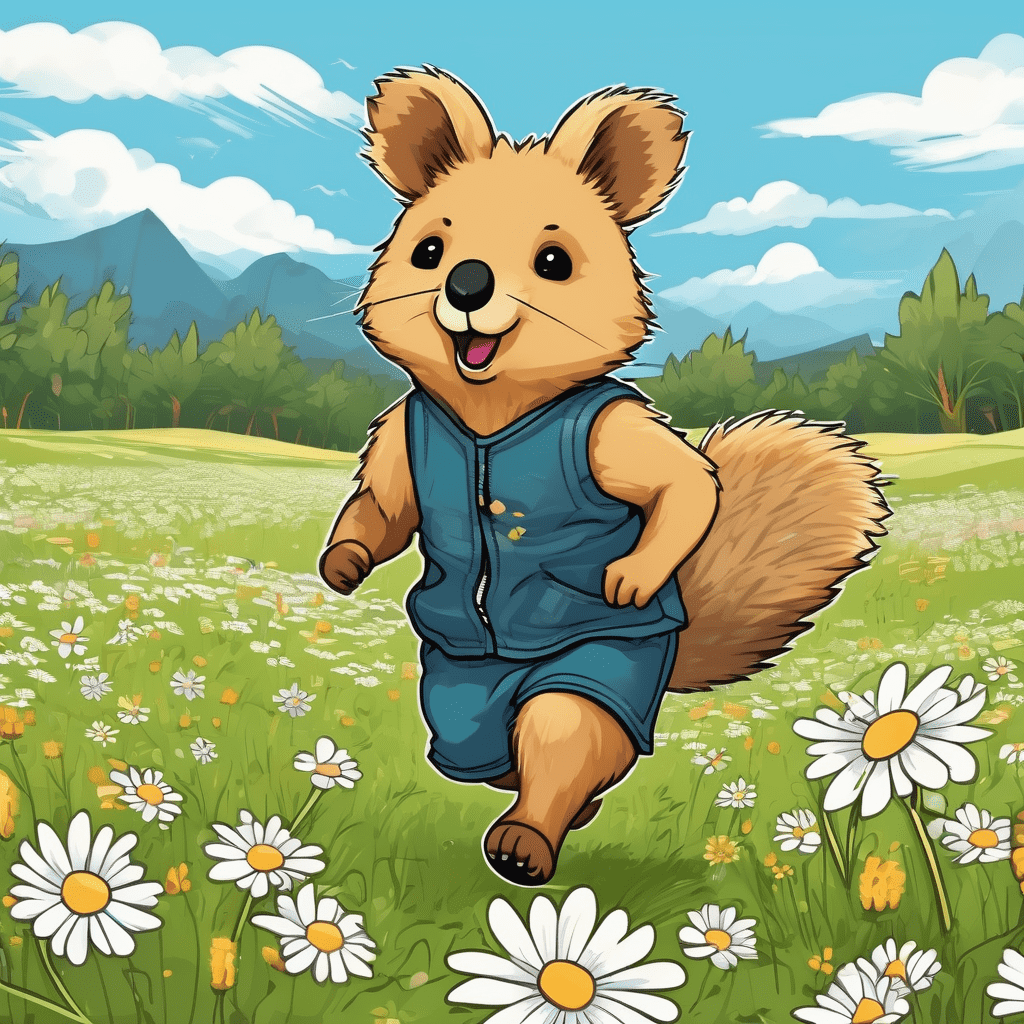

Искусство с AI становится простым с Stable Diffusion Online

Stable Diffusion Online революционизирует создание цифрового искусства с AI, предоставляя удобную платформу как для новичков, так и для экспертов. Это идеальный инструмент для каждого, кто хочет изучить Stable Diffusion AI без необходимости специальных технических знаний. Интерфейс разработан для удобства, позволяя пользователям быстро превращать идеи в яркие визуальные образы. Это не просто AI-генератор изображений; это мост, соединяющий творчество и технологии, обеспечивая, чтобы процесс создания искусства был увлекательным и доступным. Независимо от того, пробуете ли вы цифровое искусство впервые или вы опытный художник, Stable Diffusion Online легко реализует ваши идеи, делая его оптимальным решением для онлайн создания искусства с помощью Stable Diffusion.

Раскройте свой творческий потенциал с генератором изображений Stable Diffusion AI

Генератор изображений Stable Diffusion AI — мощный инструмент для художников и дизайнеров, предназначенный для создания сложных, высококачественных изображений. Этот инструмент идеален для тех, кто стремится внедрить ИИ в свой творческий процесс, предлагая непревзойденные детали и возможности настройки. Это больше, чем просто инструмент для AI Stable Diffusion; это партнер в творчестве, воплощающий детализированные пейзажи, сложные дизайны и концептуальное искусство с точностью. Будь то для цифрового маркетинга или личных проектов, этот генератор изображений на базе ИИ помогает создавать уникальные, впечатляющие произведения искусства. Генератор изображений Stable Diffusion AI выделяется своей способностью справляться со сложными художественными замыслами, делая его незаменимым инструментом для всех, кто хочет раскрыть потенциал ИИ в создании изображений.

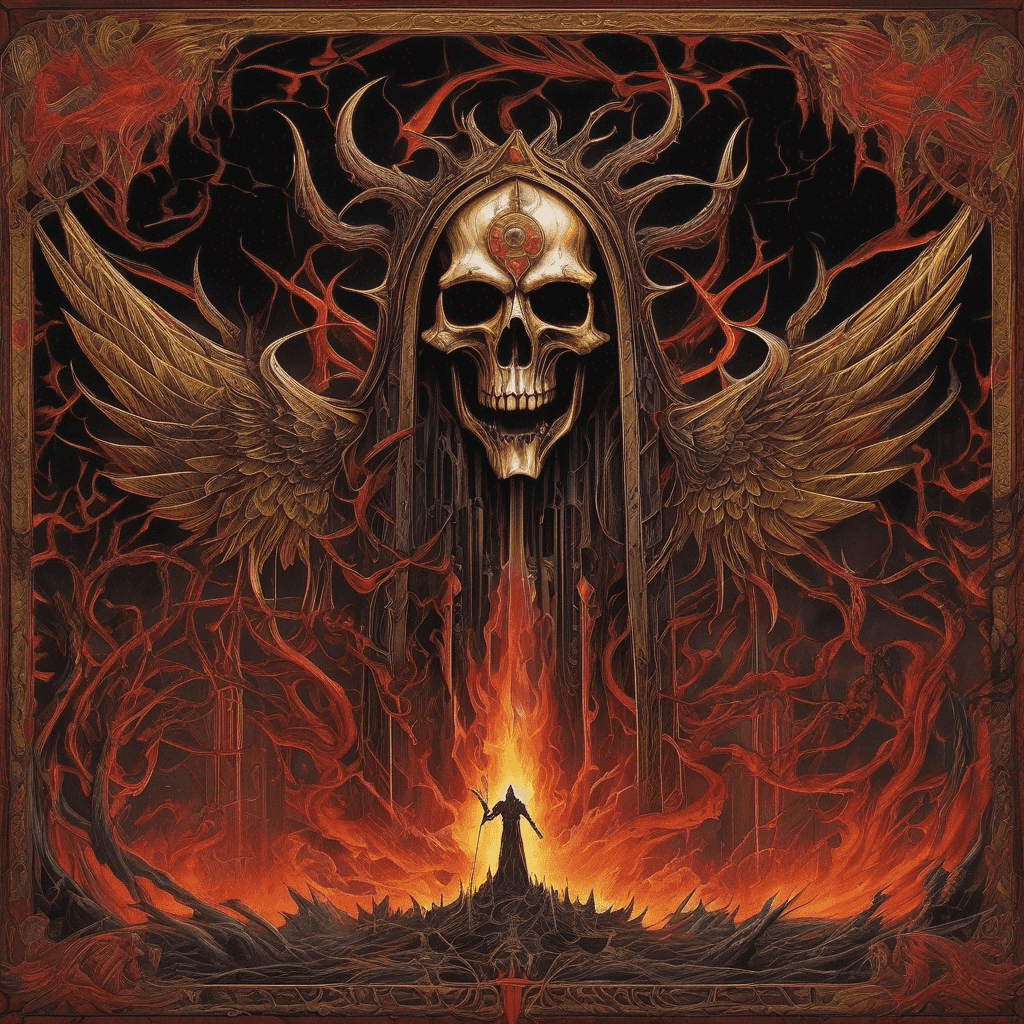

AI-искусство высокого разрешения с помощью Stable Diffusion XL Online

Stable Diffusion XL Online поднимает создание AI-искусства на новые высоты, сосредотачиваясь на высоком разрешении и детализированных изображениях. Эта платформа идеально подходит для профессиональных проектов, обеспечивая выдающееся качество цифрового искусства и дизайна. Специализируясь на ультра-высококачественных выходных изображениях, она является идеальным инструментом для создания крупномасштабных произведений и детализированных цифровых работ. Stable Diffusion XL Online — это больше, чем просто инструмент для Stable Diffusion Online; это портал к исследованию обширных творческих возможностей с использованием ИИ. Он превосходен в преобразовании сложных идей в визуальные шедевры высокого качества, идеально подходящие как для коммерческих, так и для художественных целей. Откройте будущее AI-искусства высокого разрешения с Stable Diffusion XL Online, где каждый элемент отображается с поразительной ясностью и точностью.

Модель Stable Diffusion XL

Stable Diffusion XL 1.0 (SDXL) — это последняя версия системы генерации изображений на базе ИИ, созданная компанией Stability AI и выпущенная в июле 2023 года. SDXL представляет собой значительное улучшение по сравнению с предыдущими версиями благодаря двухмодельной системе с 6 миллиардами параметров, обеспечивающей разрешение 1024x1024, высокореалистичную генерацию изображений, способность к созданию читаемого текста, упрощенные подсказки с использованием меньшего количества слов и встроенные предустановленные стили. Stable Diffusion XL представляет собой значительный прогресс в качестве, гибкости и творческом потенциале генерации изображений на базе ИИ по сравнению с предыдущими версиями Stable Diffusion.

Что такое Stable Diffusion ИИ

Stable Diffusion — это открытая система искусственного интеллекта для создания реалистичных изображений и редактирования уже существующих. Она использует модель глубокого обучения, обученную на миллионах пар «текст — изображение». Stable Diffusion создает изображения, соответствующие текстовому запросу. Пользователи могут получить доступ к ней через сайты, такие как Stablediffusionai.ai, или запускать её локально. Stable Diffusion представляет собой прорыв в области публично доступного ИИ для генерации изображений. Несмотря на такие ограничения, как систематические ошибки в данных обучения, она предоставляет художникам и создателям небывалую творческую свободу. При ответственном использовании, Stable Diffusion предоставляет уникальные возможности для искусства, медиа и других областей.

Как пользоваться Stable Diffusion AI

Stable Diffusion — это генератор изображений на основе искусственного интеллекта. Чтобы воспользоваться им, перейдите на сайт stablediffusionai.ai. Введите текстовый запрос, описывающий изображение, которое вы хотите создать. Настройте параметры, такие как размер и стиль изображения. Нажмите "'Dream'", чтобы сгенерировать изображение. Выберите понравившееся изображение и скачайте его или поделитесь им. Улучшайте результаты, корректируя запросы и настройки. Вы также можете редактировать изображения с помощью функций инпейнтинга (восстановление деталей) и аутпейнтинга (добавление деталей за пределами изображения). Stable Diffusion предоставляет широкие творческие возможности при вдумчивом использовании.

Как скачать Stable Diffusion AI

Stable Diffusion доступен на GitHub. Чтобы скачать его, перейдите на github.com/CompVis/stable-diffusion и нажмите зеленую кнопку "Code". Выберите "Download ZIP", чтобы скачать исходный код и веса параметров модели. После скачивания распакуйте ZIP-файл. Вам потребуется не менее 10 ГБ свободного места на диске. Для использования Stable Diffusion вам также потребуется Python и видеокарта с не менее чем 4 ГБ видеопамяти. В качестве альтернативы, вы можете использовать Stable Diffusion на таких сайтах, как Stablediffusionai.ai, без необходимости установки на локальный компьютер. Stable Diffusion предлагает беспрецедентный доступ к мощному ИИ-генератору изображений. Скачайте его и раскройте свой творческий потенциал.

Как установить Stable Diffusion AI?

Для установки Stable Diffusion потребуется ПК с Windows 10 или 11, GPU с минимум 4 ГБ видеопамяти и установленный Python. Скачайте кодовый репозиторий Stable Diffusion и распакуйте его. Скачайте файл контрольной точки предварительно обученной модели и файл конфигурации, а затем поместите их в нужные папки. Запустите файл webui-user.bat, чтобы открыть веб-интерфейс. Теперь вы можете создавать изображения, вводя текстовые подсказки. Настраивайте параметры, такие как количество шагов семплирования и вывода. Установите расширения, например, Automatic1111, для расширения функциональности. С правильной настройкой вы сможете локально использовать этот мощный генератор изображений на основе ИИ.

Как обучить Stable Diffusion AI?

Для обучения собственной модели Stable Diffusion вам потребуется набор данных с парами изображение-текст, GPU с достаточной видеопамятью и технические навыки. Сначала подготовьте и очистите ваши данные для обучения. Затем измените конфигурационные файлы Stable Diffusion, чтобы указать на ваш набор данных. Установите гиперпараметры, такие как размер пакета и скорость обучения. Запустите скрипты для обучения VAE, UNet и текстового кодировщика отдельно. Обучение требует больших вычислительных ресурсов, поэтому при необходимости арендуйте облачный GPU. Отслеживайте прогресс обучения. После завершения оцените производительность модели. При необходимости дорабатывайте её, пока не добьётесь удовлетворительного результата. Со временем, вычислительными ресурсами и усилиями вы сможете настроить Stable Diffusion под свои конкретные задачи.

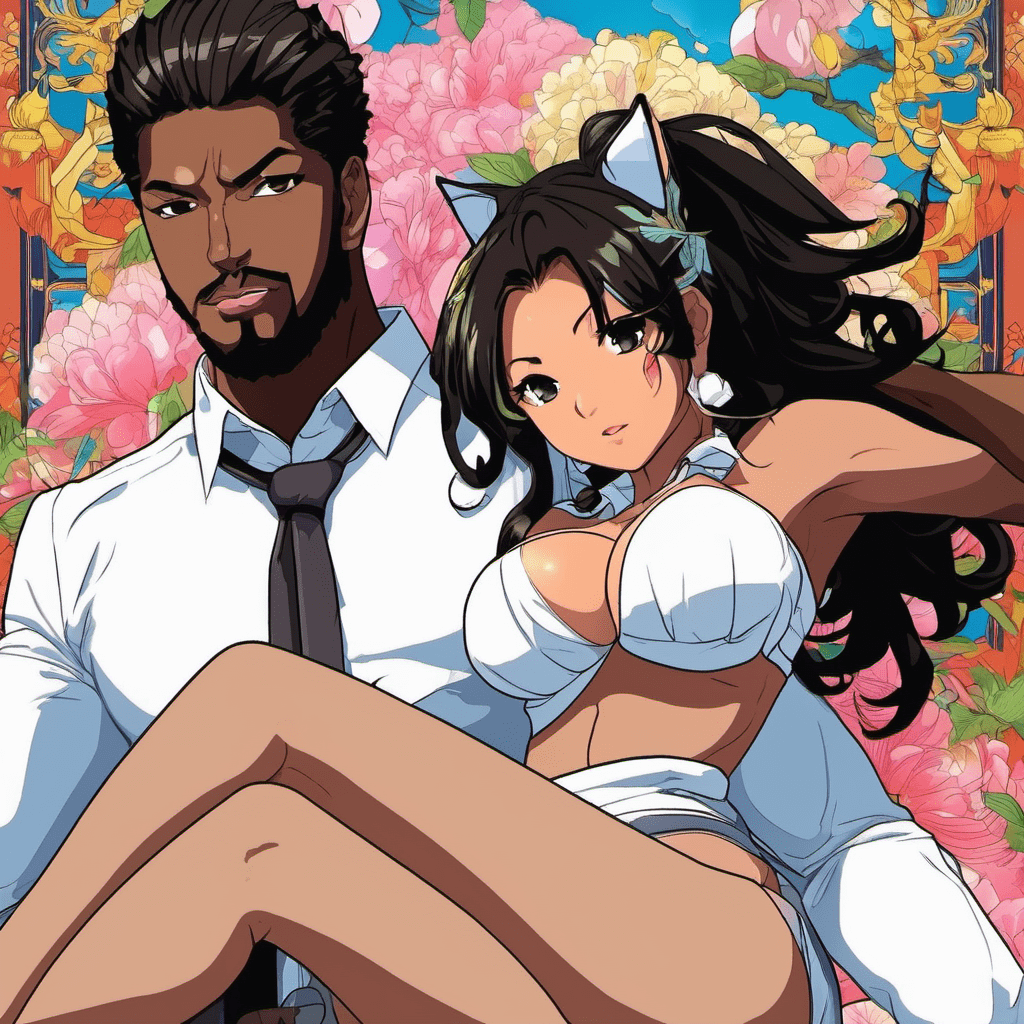

Что такое Lora в Stable Diffusion?

Lora (сокращение от Learned Regional Augmentation — Усовершенствованное Региональное Обучение) — это техника, используемая для улучшения моделей Stable Diffusion. Loras представляют собой небольшие нейронные сети, которые обучаются на наборах данных изображений и позволяют модели точно генерировать определенные детали, такие как лица, руки или одежда. Чтобы использовать Lora, скачайте её и переместите в соответствующую папку. Добавьте ключевое слово Lora в свои команды для её активации. Loras обеспечивают больший контроль над деталями без необходимости повторного обучения всей модели. Они позволяют адаптировать Stable Diffusion для создания аниме-персонажей, портретов, моделей одежды и многого другого. С правильными Lora вы сможете вывести Stable Diffusion на новый уровень детализации и настройки.

Что такое негативная подсказка в Stable Diffusion AI

В Stable Diffusion негативные подсказки позволяют указать то, что вы не хотите видеть на созданном изображении. Это просто слова или фразы, сообщающие модели, чего следует избегать. Например, добавление 'плохой рисунок, некрасивость, лишние пальцы' в качестве негативной подсказки снижает вероятность появления таких нежелательных элементов. Негативные подсказки дают больше контроля над процессом генерации изображений. Они помогают исключить распространённые дефекты, такие как искажения или артефакты. Использование негативных и положительных подсказок помогает точнее настроить модель на получение желаемого результата. Эффективное использование негативных подсказок улучшает качество и точность изображений, создаваемых с помощью Stable Diffusion.

Требуется ли интернет для работы Stable Diffusion AI?

Stable Diffusion может работать полностью без подключения к интернету после установки на локальный компьютер. Интернет потребуется только для первоначальной загрузки исходного кода и файлов модели. После установки вы сможете генерировать изображения через локальный веб-интерфейс без подключения к интернету. Stable Diffusion выполняет вычисления полностью на вашем локальном GPU, что делает его более конфиденциальным и безопасным по сравнению с облачными сервисами. Однако доступ к Stable Diffusion через веб-сайты требует постоянного подключения к интернету. Работа на локальном компьютере позволяет использовать его в самолётах, в удалённых районах или там, где интернет ограничен. Таким образом, хотя для доступа через веб требуется интернет, сам по себе Stable Diffusion не нуждается в подключении при локальной установке.

Как использовать эмбеддинги в Stable Diffusion Stable Diffusion AI

Эмбеддинги позволяют моделям Stable Diffusion создавать изображения в заданном визуальном стиле. Чтобы использовать эмбеддинги, сначала обучите их на изображениях, представляющих нужный стиль. Поместите файл эмбеддинга в соответствующую папку. В текстовом запросе введите имя эмбеддинга в двоеточиях, например [:Name:], чтобы активировать его. Stable Diffusion сгенерирует изображения, соответствующие этому стилю. Настройте параметр силы, чтобы контролировать эффект. Эмбеддинги, мощный инструмент для получения стабильных результатов. С правильными эмбеддингами вы сможете адаптировать Stable Diffusion для создания определённых произведений искусства, эстетики и других визуальных стилей.

Часто задаваемые вопросы

Что такое 'Stable difusion' и 'Stable difussion'?

'Stable difusion' и 'Stable difussion' — это опечатки слова 'Stable Diffusion'. Отдельных платформ с такими названиями не существует. 'Stable Diffusion' — это правильное название инструмента для генерации изображений с помощью ИИ, известного своей способностью преобразовывать текст в изображения. Эти опечатки часто встречаются, но они относятся к одной и той же технологии.

Как связано Stability Diffusion XL со Stable Diffusion?

Stability Diffusion XL — это продвинутая версия Stable Diffusion, специализирующаяся на создании изображений высокого разрешения. Stable Diffusion предназначен для генерации изображений на основе ИИ, а Stability Diffusion XL улучшает детализацию и чёткость изображений, что делает его идеальным выбором для высококачественных профессиональных проектов.

Введение в Stable Diffusion

Stable Diffusion — это открытый инструмент для генерации изображений по текстовому описанию на основе моделей диффузии, разработанный командой CompVis из Людвиг-Максимилианского университета в Мюнхене и Runway ML при поддержке вычислительных мощностей Stability AI. Он может генерировать изображения высокого качества по текстовому описанию, а также выполнять восстановление изображений (inpainting), расширение изображений (outpainting) и текстово-ориентированную трансляцию изображений (image-to-image translation). Stable Diffusion опубликовал исходный код, предварительно обученные модели и лицензию, что позволяет пользователям запускать его на одном графическом процессоре (GPU). Это делает его первой моделью глубокого обучения с открытым исходным кодом для генерации изображений по тексту, которую можно запускать локально на устройствах пользователей.

Как работает Stable Diffusion?

Stable Diffusion использует архитектуру диффузионной модели, называемую Latent Diffusion Models (LDM). Она состоит из трёх компонентов: вариационного автокодировщика (VAE), U-Net и дополнительного текстового кодировщика. VAE сжимает изображение из пиксельного пространства в более компактное латентное пространство, захватывая более фундаментальную семантическую информацию. В ходе прямой диффузии итеративно добавляется гауссовский шум к сжатому латентному представлению. Блок U-Net (состоящий из основы ResNet) деносирует результат прямой диффузии, чтобы получить латентное представление. Наконец, декодер VAE генерирует окончательное изображение, преобразуя представление обратно в пиксельное пространство. Текстовое описание передается в U-Net через механизм перекрёстного внимания (cross-attention), чтобы направить генерацию изображений.

Обучающие данные для Stable Diffusion

Stable Diffusion обучался на наборе данных LAION-5B, который содержит пары изображение-текст, полученные из Common Crawl. Данные были классифицированы по языкам и отфильтрованы в подмножества с более высоким разрешением, меньшей вероятностью водяных знаков и более высокими предсказанными 'эстетическими' оценками. В последние раунды обучения также было включено 10% текстов без учёта текстовых условий, чтобы улучшить механизм диффузионного управления без классификатора (Classifier-Free Diffusion Guidance).

Возможности Stable Diffusion

Stable Diffusion может генерировать новые изображения с нуля на основе текстовых подсказок, перерабатывать существующие изображения с добавлением новых элементов, указанных в тексте, а также изменять изображения с помощью технологий inpainting и outpainting. Он также поддерживает использование 'ControlNet' для изменения стиля и цвета изображения с сохранением его геометрической структуры. Возможна также замена лиц. Все эти функции предоставляют пользователям большие возможности для творчества.

Доступ к Stable Diffusion

Пользователи могут скачать исходный код для настройки Stable Diffusion на своём устройстве или получить доступ к его API через официальный сайт Dream Studio. Dream Studio предоставляет простой и интуитивно понятный интерфейс и различные инструменты настройки. Пользователи также могут получить доступ к API Stable Diffusion через сторонние сайты, такие как Hugging Face и Civitai, которые предлагают различные модели Stable Diffusion для создания изображений в разных стилях.

Ограничения Stable Diffusion

Основным ограничением Stable Diffusion является смещение в его обучающих данных, которые в основном получены с англоязычных веб-страниц. Это приводит к смещению результатов в сторону западной культуры. Также модель испытывает трудности с генерацией человеческих конечностей и лиц. Некоторые пользователи также сообщают, что Stable Diffusion 2 работает хуже, чем серия Stable Diffusion 1, при изображении знаменитостей и художественных стилей. Однако пользователи могут расширить возможности модели через дообучение. В целом, Stable Diffusion — это мощная и постоянно развивающаяся модель глубокого обучения с открытым исходным кодом для генерации изображений по текстовому описанию, предоставляющая пользователям большие возможности для творчества. Однако мы должны также учитывать возможные искажения, связанные с обучением модели, и нести ответственность за генерируемый контент при использовании этой модели.

,%20(Masterfully%20crafted%20Glow),%20hyper%20details,(delicate%20detailed).png)

%20as%20Harley%20Quinn%20(DC%20Comics).png)

);%20blue%20eyes.png)