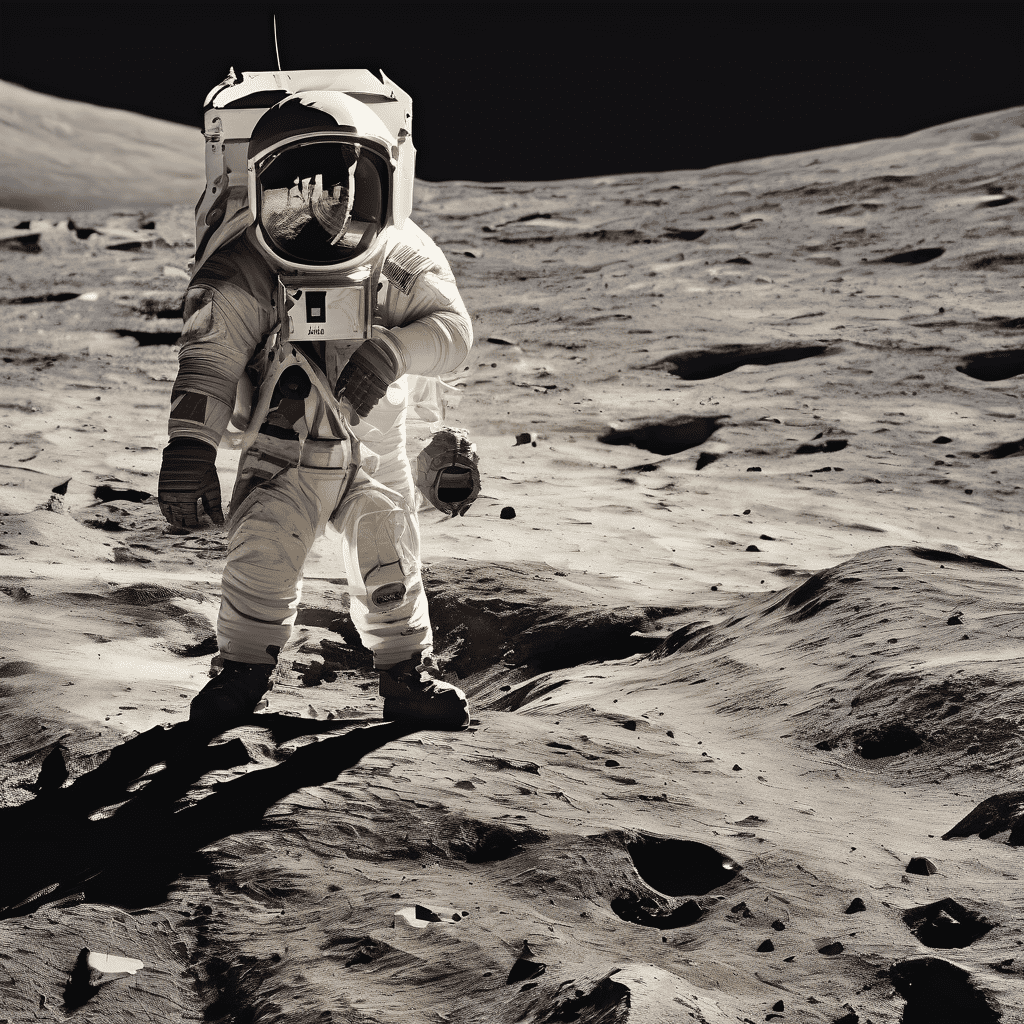

AIアート生成ツールでテキストを画像に変換

Stable Diffusion Onlineで簡単にAIアートを作成

Stable Diffusion Onlineは、初心者から専門家まで幅広いユーザーに対応した、AIアート作成の画期的なプラットフォームです。専門的な技術知識がなくても、AI画像生成を簡単に楽しむことができる完璧なツールです。直感的なインターフェースにより、アイデアをすぐに魅力的なビジュアルに変換できます。単なるAI画像生成ツールではなく、創造性と技術を結ぶ架け橋であり、アート作成のプロセスを楽しみながら誰でも簡単に使えます。デジタルアートに初めて挑戦する方でも、経験豊富なアーティストでも、Stable Diffusion Onlineはあなたのビジョンを簡単に実現し、オンラインでの安定したアート生成の頼れるソリューションとなります。

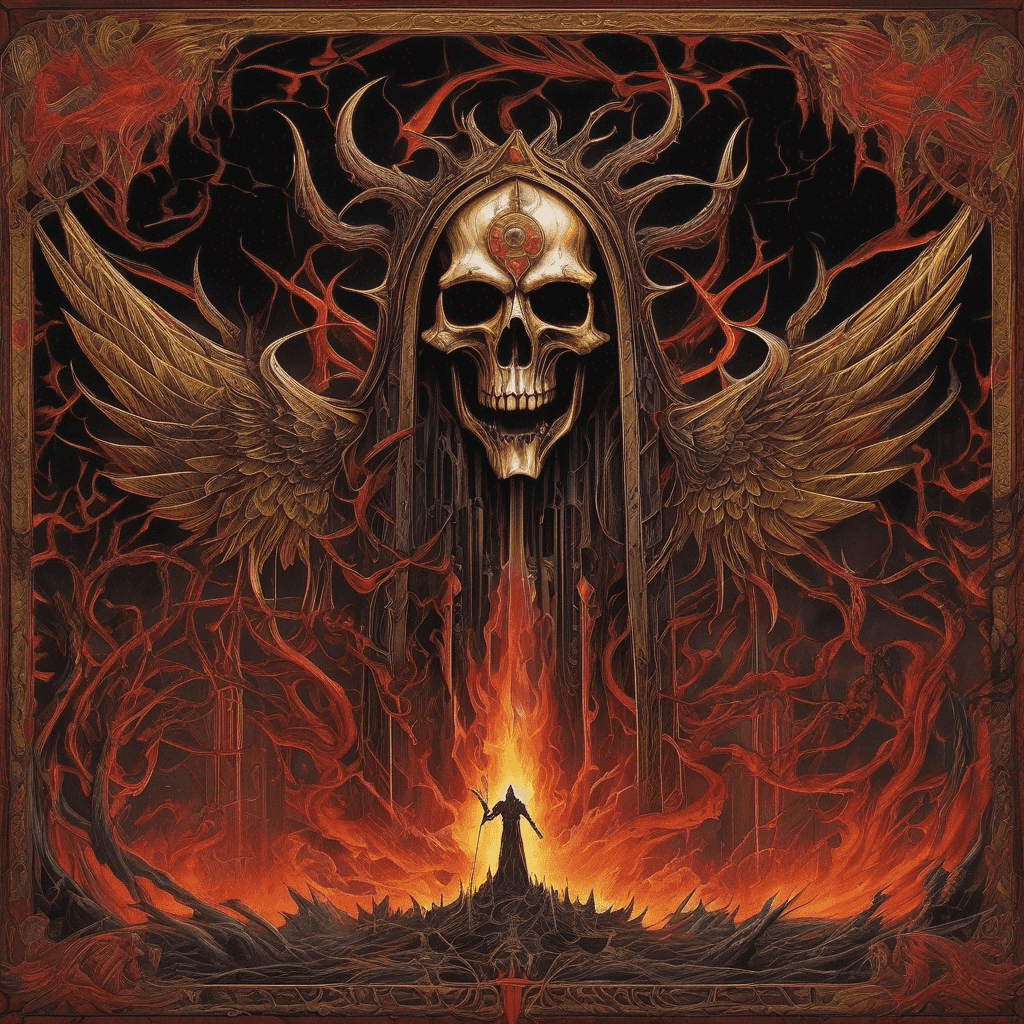

Stable Diffusion AIでアートをもっと高めよう

Stable Diffusion AI画像生成は、アーティストやデザイナーにとって心強い味方です。このツールは、複雑で高品質な画像を生成するために設計されており、AIをクリエイティブプロセスに取り入れたい方に最適です。詳細な風景や複雑なデザイン、コンセプチュアルアートを正確に描写する能力を持ち、デジタルマーケティングや個人プロジェクトに活用できる、ユニークで印象的な作品を生み出します。Stable Diffusion AI画像生成は、アートにおけるAIの可能性を最大限に活用したい方にとって、欠かせない存在です。

Stable Diffusion XLで楽しむ高解像度AIアート

Stable Diffusion XLオンラインは、AIアート作成を新たな次元へと導き、高解像度で詳細な画像生成に特化しています。このプラットフォームはプロフェッショナル向けのプロジェクトにぴったりで、デジタルアートやデザインにおいて卓越したクオリティを実現します。超高解像度の出力に特化しているため、大規模なアート作品や詳細なデジタル作品の制作に理想的なツールです。Stable Diffusion XLオンラインは、単なるStable Diffusionのツールを超え、AIによる広大な創造的可能性を探求するための入り口です。複雑なアイデアを高品質なビジュアルに変換し、商業および芸術的な取り組みに最適です。クリアな細部まで美しく描かれる高解像度AIアート制作の未来を、Stable Diffusion XLオンラインで体感してください。

Stable Diffusion XL モデル

Stable Diffusion XL 1.0(SDXL)は、Stability AIによって開発され、2023年7月にリリースされた最新のAI画像生成システムです。SDXLは、60億のパラメータを持つデュアルモデルシステムにより、1024x1024の高解像度、非常にリアルな画像の生成、読みやすいテキストの生成、簡単なプロンプト、そして組み込みのプリセットスタイルを実現します。Stable Diffusion XLは、従来のバージョンと比較して、AIによる画像生成の品質、柔軟性、創造的可能性において大きな飛躍を遂げたものです。

What is Stable Diffusion AIとは

Stable Diffusionは、リアルな画像を生成および既存の画像を編集するためのオープンソースのAIシステムです。数百万の画像とテキストペアを学習したディープラーニングモデルを使用しています。テキストプロンプトを入力すると、Stable Diffusionはその内容に沿った画像を作成します。ユーザーは、Stablediffusionai.aiなどのウェブサイト経由でアクセスするか、ローカルで実行することができます。Stable Diffusionは、公開されているAI画像生成技術の中で画期的な存在です。訓練データの偏りなどの制約はあるものの、アーティストやクリエイターにこれまでにない創造の自由を提供します。正しく使用すれば、Stable Diffusionはアートやメディアなど、さまざまな分野での可能性を秘めています。

Stable Diffusion AIの使い方

Stable DiffusionはAI画像生成のツールです。利用するには、stablediffusionai.aiにアクセスしてください。希望する画像の説明をテキストプロンプトに入力し、画像サイズやスタイルなどの設定を調整します。「Dream」ボタンをクリックして画像を生成します。気に入った画像を選んでダウンロードまたは共有できます。プロンプトや設定を調整して、望みの結果を得ることができます。また、インペイントやアウトペイント機能で画像を編集することも可能です。Stable Diffusionは、うまく活用すれば、大きな創造の自由を得ることができます。

Stable Diffusion AIのダウンロード方法

Stable DiffusionはGitHubでダウンロードできます。ダウンロードするには、github.com/CompVis/stable-diffusion にアクセスし、緑の「Code」ボタンをクリックします。「Download ZIP」を選択して、ソースコードとモデルウェイト(学習済みモデル)をダウンロードします。ダウンロード後、ZIPファイルを解凍してください。最低でも10GBの空きディスク容量が必要です。また、Stable Diffusionを使用するには、Pythonと少なくとも4GBのVRAMを持つGPUが必要になります。あるいは、Stablediffusionai.ai などのウェブサイトを通じて、インストールなしでStable Diffusionを利用できます。Stable Diffusionは、これまでにないAI画像生成ツールのアクセスを提供します。ダウンロードして、創造力を解き放ちましょう!

Stable Diffusion AIのインストール

Stable Diffusionをインストールするには、Windows 10または11、少なくとも4GBのVRAMを持つGPU、およびPythonが必要です。まず、Stable Diffusionのコードリポジトリをダウンロードして解凍します。次に、事前にトレーニングされたモデルのチェックポイントファイルと設定ファイルを取得し、それらを適切なフォルダに配置します。webui-user.batファイルを実行して、Web UIを立ち上げます。これで、テキストプロンプトを入力して画像を生成できるようになります。サンプリングステップや推論回数などの設定を調整してください。Automatic1111などの拡張機能をインストールすることで、さらに多くの機能を利用できます。適切な設定が整えば、この強力なAI画像生成ツールをローカル環境で使用できます。

Stable Diffusion AIのトレーニング

独自のStable Diffusionモデルをトレーニングするには、画像とテキストのペアからなるデータセット、十分なVRAMを持つGPU、および技術的スキルが必要です。まず、トレーニングデータを準備し、クリーンアップします。次に、Stable Diffusionの設定ファイルを変更してデータセットを参照するように設定ファイルを変更します。バッチサイズや学習率などのハイパーパラメータを設定します。トレーニングスクリプトを実行して、VAE、UNet、テキストエンコーダーを個別にトレーニングします。トレーニングは計算リソースを大量に消費するため、必要に応じてクラウドGPUインスタンスをレンタルします。トレーニングの進行状況を監視し、終了後にモデルのパフォーマンスを評価します。必要に応じて微調整を行い、満足のいく結果が得られるまでトレーニングを繰り返します。時間と計算リソース、そして努力を注ぐことで、特定のニーズに合わせたStable Diffusionをカスタマイズできます。

Lora(Stable Diffusion)とは?

Lora(学習済み領域拡張の略)は、Stable Diffusionモデルを強化するための技術です。Loraは、小型のニューラルネットワークであり、顔や手、服装など、特定のディテールに特化したモデルとして画像データセットを用いて訓練されます。Loraを使用するには、まずダウンロードして適切なフォルダに保存し、プロンプトにLoraのキーワードを追加してアクティベートします。Loraを使用すると、モデル全体を再学習せずに詳細をより制御でき、Stable Diffusionをカスタマイズして、アニメキャラクターやポートレート、ファッションモデルなどを生成できます。適切なLoraを使うことで、新たなレベルのディテールとカスタマイズが可能になります。

ネガティブプロンプトとは?

Stable Diffusionでは、ネガティブプロンプトを使って、画像に含めたくない要素を指定できます。これは、モデルに避けるべき要素を指示する単語やフレーズです。例えば、「poorly drawn, ugly, extra fingers(下手な描画、醜い、余分な指)」をネガティブプロンプトとして追加すると、これらの不要な要素が現れにくくなります。ネガティブプロンプトは、画像生成プロセスをより制御するために役立ちます。歪みやアーティファクトなど、一般的な欠陥を排除するのに便利です。ポジティブプロンプトと一緒にネガティブプロンプトを指定することで、モデルを望む出力に誘導することができます。ネガティブプロンプトを効果的に使うことで、Stable Diffusionが生成する画像の品質と精度が向上します。

Stable Diffusion AIにインターネット接続は必要ですか?

Stable Diffusionは、ローカルにインストールすれば完全にオフラインで実行できます。必要なのは、初めにソースコードやモデルファイルをダウンロードする際のインターネット接続だけです。セットアップ後は、ローカルのWeb UIを介してインターネットに接続せずに画像を生成できます。Stable DiffusionはローカルGPUで推論を行うため、クラウドベースのサービスに比べてプライバシーとセキュリティがより高まります。しかし、Webサイト経由でStable Diffusionにアクセスするには常にインターネット接続が必要です。ローカルで実行することで、飛行機内、遠隔地、またはインターネットが制限されている場所でも利用可能になります。つまり、Webアクセスにはインターネットが必要ですが、ローカルでホスティングする場合、Stable Diffusion自体はオンライン接続を必要としません。

エンベディングの使い方 Stable Diffusion AI

エンベディングを使用すると、Stable Diffusionモデルが特定のビジュアルスタイルを再現した画像を生成できます。エンベディングを使用するには、まず目的のスタイルを表す画像データセットでエンベディングを学習させます。次に、エンベディングファイルをエンベディングフォルダに保存します。テキストプロンプトに、エンベディングの名前をコロンで囲んで[:Name:]のように追加して有効にします。Stable Diffusionはそのスタイルに合った画像を生成します。強度パラメータを調整して、エフェクトを調整できます。エンベディングは一貫した出力を得るのに効果的です。適切なエンベディングを使用することで、特定のアートワーク、美的スタイル、その他のビジュアルスタイルに合わせてStable Diffusionをカスタマイズできます。

よくある質問

'Stable difusion'や'Stable difussion'とは?

'Stable difusion'や'Stable difussion'は、'Stable Diffusion'のスペルミスです。これらの名前の別のプラットフォームはありません。'Stable Diffusion'が正しい名称であり、テキストから画像を生成するAIツールです。これらのスペルミスは一般的ですが、同じ技術を指しています。

Stability Diffusion XLはStable Diffusionとどう関係していますか?

Stability Diffusion XLは、Stable Diffusionの高度なバージョンであり、高解像度の画像生成に特化しています。Stable DiffusionがAIによるアート生成に焦点を当てている一方で、Stability Diffusion XLはより高いディテールと鮮明さを提供し、プロフェッショナルなプロジェクトに最適です。

Stable Diffusionの概要

Stable Diffusionは、CompVisグループ(ミュンヘン大学)とRunway MLが開発し、Stability AIがコンピューティングサポートを提供した、ディフュージョンモデルに基づくオープンソースのテキストから画像生成ツールです。テキスト記述から高品質な画像を生成できるほか、画像のインペインティング、アウトペインティング、テキストに基づく画像間翻訳も可能です。Stable Diffusionは、コード、事前学習済みモデル、ライセンスをオープンソース化しており、単一のGPU上で実行できます。これにより、ユーザーは自分のデバイス上で初めてローカルに動作するオープンソースのテキストから画像生成モデルを利用できるようになりました。

Stable Diffusionの仕組み

Stable Diffusionは、Latent Diffusion Models (LDM)と呼ばれるディフュージョンモデルアーキテクチャを使用しています。これには、変分オートエンコーダー(VAE)、U-Net、およびオプションのテキストエンコーダーの3つのコンポーネントが含まれます。VAEは画像をピクセル空間から小さな潜在空間に圧縮し、より基本的な意味情報をキャプチャします。ガウスノイズは、順方向ディフュージョン中に圧縮された潜在空間に繰り返し追加されます。U-Netブロック(ResNetバックボーンを含む)は、順方向ディフュージョンからの出力を逆方向にノイズ除去し、潜在表現を取得します。最後に、VAEデコーダーがこの表現を再びピクセル空間に変換して最終画像を生成します。テキスト記述はクロスアテンションメカニズムを通じてノイズ除去U-Netに公開され、画像生成をガイドします。

Stable Diffusionのトレーニングデータ

Stable Diffusionは、Common CrawlからスクレイピングされたLAION-5Bデータセット上でトレーニングされました。このデータには、言語別に分類され、解像度が高く、ウォーターマークの可能性が低く、予測「美的」スコアが高いサブセットが含まれています。トレーニングの最終ラウンドでは、テキストコンディショニングの10%を削除してClassifier-Free Diffusion Guidanceを改善しました。

Stable Diffusionの機能

Stable Diffusionは、テキストプロンプトに基づいて新しい画像をゼロから生成したり、テキストで説明された新しい要素を取り入れて既存の画像を再描画したり、インペインティングやアウトペインティングを通じて既存の画像を修正することができます。また、「ControlNet」を使用して、幾何構造を維持しながら画像のスタイルや色を変更することも可能です。顔の交換もできます。これにより、ユーザーに大きな創造的自由が提供されます。

Stable Diffusionへのアクセス

ユーザーは、ソースコードをダウンロードしてStable Diffusionをローカルに設定するか、公式サイトDream Studioを通じてAPIにアクセスできます。Dream Studioは、シンプルで直感的なインターフェースとさまざまな設定ツールを提供しています。また、Hugging FaceやCivitaiなどのサードパーティサイトを通じてStable Diffusion APIにアクセスすることもでき、さまざまな画像スタイルに対応したStable Diffusionモデルを提供しています。

Stable Diffusionの制限事項

Stable Diffusionの主な制限は、トレーニングデータには偏りがあり、主に英語のウェブページから収集されています。これにより、結果が西洋文化に偏りがちです。また、人間の手足や顔の生成に苦労することがあります。Stable Diffusion 2は、セレブリティや芸術スタイルの描写において、Stable Diffusion 1シリーズよりも劣ると報告するユーザーもいます。しかし、ユーザーはファインチューニングを通じてモデルの機能を拡張できます。 まとめると、Stable Diffusionは強力で進化し続けるオープンソースの深層学習テキストから画像生成モデルであり、ユーザーに大きな創造的自由を提供します。しかし、トレーニングデータに起因する偏りの可能性に注意を払い、責任を持って使用する必要があります。

,%20(Masterfully%20crafted%20Glow),%20hyper%20details,(delicate%20detailed).png)

%20as%20Harley%20Quinn%20(DC%20Comics).png)

);%20blue%20eyes.png)