De texto a imagen con IA

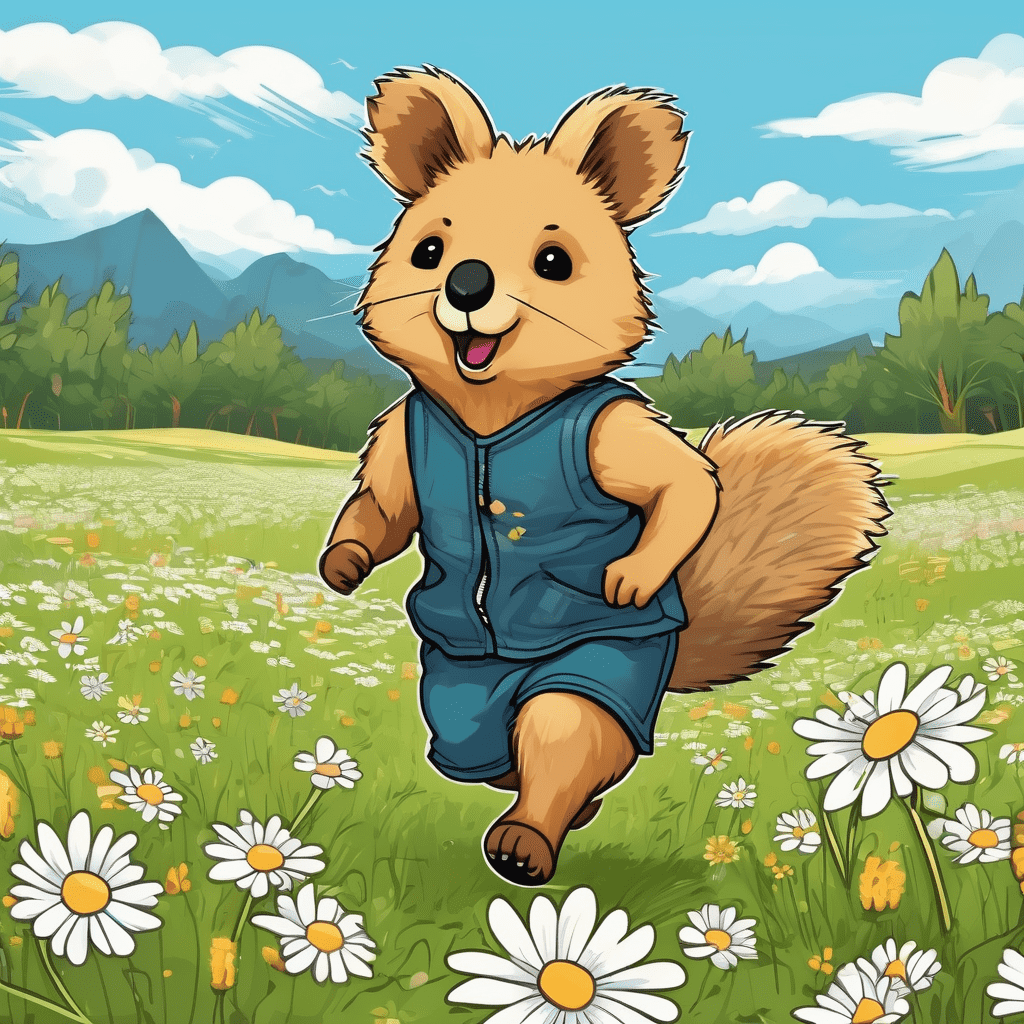

Arte con IA, Simplificado con Stable Diffusion Online

Stable Diffusion Online revoluciona la creación de arte con IA, ofreciendo una plataforma fácil de usar para principiantes y expertos. Es la herramienta perfecta para quienes desean explorar la difusión estable de IA sin necesidad de conocimientos técnicos profundos. La interfaz está diseñada para ser intuitiva y fácil de usar, permitiendo a los usuarios transformar rápidamente sus ideas en imágenes atractivas. No es solo un generador de imágenes con IA; es un vínculo entre la creatividad y la tecnología, asegurando que el proceso de creación artística sea tanto agradable como accesible. Ya sea que estés incursionando en el arte digital por primera vez o seas un artista experimentado, Stable Diffusion Online da vida a tus ideas de manera fluida, convirtiéndose en la mejor opción para crear arte con IA en línea.

Potencia tu creatividad con el Generador de Imágenes con IA de Stable Diffusion

El Generador de Imágenes con IA de Stable Diffusion es una herramienta potente para artistas y diseñadores, creada para producir imágenes complejas y de alta calidad. Este generador es ideal para quienes desean integrar la IA en su proceso creativo, ofreciendo un nivel de detalle y personalización inigualables. No es solo una herramienta de IA; es un aliado en la creatividad, capaz de crear paisajes detallados, diseños intrincados y arte conceptual con precisión. Ya sea para marketing digital o proyectos personales, este generador de imágenes con IA permite crear obras de arte únicas y llamativas. El Generador de Imágenes con IA de Stable Diffusion se destaca por su capacidad para manejar visiones artísticas complejas, convirtiéndose en una herramienta indispensable para quien quiera aprovechar el potencial de la IA en su arte.

Arte con IA de Alta Resolución con Stable Diffusion XL Online

Stable Diffusion XL Online eleva la creación de arte con IA a nuevas alturas, centrándose en imágenes detalladas y de alta resolución. Esta plataforma está diseñada para proyectos de nivel profesional, ofreciendo una calidad excepcional para arte digital y diseño. Especializada en imágenes de ultra alta resolución, es la herramienta perfecta para crear obras de arte a gran escala y piezas digitales detalladas. Stable Diffusion XL Online es más que solo una herramienta en línea de Stable Diffusion; es una puerta de entrada para explorar vastas posibilidades creativas con IA. Destaca por transformar ideas complejas en obras visuales de alta calidad, perfectas tanto para proyectos comerciales como artísticos. Adopta el futuro de la creación de arte con IA de alta resolución con Stable Diffusion XL Online, donde cada detalle se captura con una claridad y precisión impresionantes.

Modelo Stable Diffusion XL

Stable Diffusion XL 1.0 (SDXL) es la última versión del sistema de generación de imágenes con IA, creado por Stability AI y lanzado en julio de 2023. SDXL introduce mejoras significativas respecto a versiones anteriores con su sistema de modelo dual de 6 mil millones de parámetros, permitiendo la generación de imágenes altamente realistas en resolución 1024x1024, texto legible, prompts simplificados con menos palabras necesarias y estilos predeterminados integrados. Stable Diffusion XL representa un avance significativo en la calidad, flexibilidad y potencial creativo de la generación de imágenes con IA en comparación con las versiones anteriores de Stable Diffusion.

Qué es Stable Diffusion AI

Stable Diffusion es un sistema de IA de código abierto para crear imágenes realistas y editar imágenes existentes. Utiliza un modelo de aprendizaje profundo entrenado con millones de pares de imágenes y textos. A partir de un texto descriptivo, Stable Diffusion crea imágenes que coinciden con la descripción. Los usuarios pueden acceder a él a través de, por ejemplo, sitios web como Stablediffusionai.ai o ejecutarlo localmente. Stable Diffusion representa un avance en la generación de imágenes con IA de acceso público. A pesar de limitaciones como el sesgo en los datos utilizados para su entrenamiento, ofrece a artistas y creadores un nivel de libertad creativa sin precedentes. Cuando se usa de manera responsable, Stable Diffusion tiene un potencial emocionante para el arte, los medios y más.

Cómo usar Stable Diffusion AI

Stable Diffusion es un generador de imágenes de IA. Para usarlo, visita stablediffusionai.ai. Escribe un texto describiendo la imagen que deseas crear. Ajusta configuraciones como el tamaño y el estilo de la imagen. Haz clic en "Soñar" para generar imágenes. Selecciona tu imagen favorita y descárgala o compártela. Refina las indicaciones y configuraciones para obtener los resultados deseados. También puedes editar imágenes con las funciones de inpainting y outpainting. Stable Diffusion brinda una gran libertad creativa si se utiliza de forma consciente.

Cómo descargar Stable Diffusion AI

Stable Diffusion está disponible en GitHub. Para descargarlo, ve a github.com/CompVis/stable-diffusion y haz clic en el botón verde "Code". Selecciona "Download ZIP" para descargar el código fuente y los parámetros del modelo. Extrae el archivo ZIP después de descargarlo. Necesitarás al menos 10 GB de espacio libre en disco. Para usar Stable Diffusion, también necesitarás Python y una GPU con al menos 4 GB de VRAM. Alternativamente, puedes acceder a Stable Diffusion a través de sitios web como Stablediffusionai.ai sin necesidad de instalarlo localmente. Stable Diffusion ofrece un acceso sin precedentes a un poderoso generador de imágenes AI. Descárgalo para liberar tu creatividad.

¿Cómo instalar la IA de Difusión Estable?

Para instalar Difusión Estable, necesitas un PC con Windows 10 u 11, una GPU con al menos 4GB de VRAM y Python instalado. Descarga el repositorio de código de Difusión Estable y extráelo. Obtén el archivo de checkpoint del modelo preentrenado y el archivo de configuración, y colócalos en las carpetas adecuadas. Ejecuta el archivo webui-user.bat para iniciar la interfaz web. Ahora puedes generar imágenes simplemente escribiendo indicaciones de texto. Ajusta configuraciones como los pasos de muestreo y los pasos de inferencia. Instala extensiones como Automatic1111 para obtener más funciones. Con la configuración adecuada, puedes ejecutar localmente este potente generador de imágenes con IA.

¿Cómo entrenar la IA de Difusión Estable?

Para entrenar tu propio modelo de Difusión Estable, necesitas un conjunto de datos de pares imagen-texto, una GPU con suficiente VRAM y habilidades técnicas. Primero, prepara y limpia tus datos de entrenamiento. Luego, modifica los archivos de configuración de Difusión Estable para que apunten a tu conjunto de datos. Establece hiperparámetros como el tamaño de lote y la tasa de aprendizaje. Ejecuta los scripts para entrenar el VAE, UNet y el codificador de texto por separado. El entrenamiento requiere mucha potencia computacional, por lo que podrías alquilar una instancia de GPU en la nube si lo necesitas. Monitorea el progreso del entrenamiento. Después de entrenar, evalúa el rendimiento del modelo. Ajusta según sea necesario hasta que estés satisfecho. Con tiempo, potencia de cálculo y esfuerzo, puedes personalizar Difusión Estable para tus necesidades específicas.

¿Qué es lora en la Difusión estable?

Lora, abreviatura de aumento regional aprendida, es una técnica utilizada para mejorar los modelos de Difusión estable. Los loras son pequeñas redes neuronales entrenadas en conjuntos de datos de imágenes para especializar un modelo en generar detalles específicos como caras, manos o vestimenta. Para usar un lora, descárgalo y colócalo en la carpeta adecuada. En tus prompts, añade la palabra clave del lora para activarlo. Los loras ofrecen más control sobre los detalles sin necesidad de reentrenar todo el modelo. Permiten personalizar la Difusión estable para generar personajes de anime, retratos, modelos de moda y más. Con los loras adecuados, puedes llevar la Difusión estable a otro nivel en términos de detalle y personalización.

¿Qué es un prompt negativo en Stable Diffusion?

En Stable Diffusion, los prompts negativos te permiten especificar elementos que no deseas ver en una imagen generada. Son simplemente palabras o frases que le indican al modelo qué debe evitar. Por ejemplo, agregar "mal hecho, feo, dedos extra" como prompt negativo reduce la probabilidad de que esos elementos no deseados aparezcan. Los prompts negativos te brindan un mayor control sobre el proceso de generación de imágenes. Son útiles para excluir errores comunes como distorsiones o artefactos. Especificar prompts negativos junto con los positivos ayuda a guiar al modelo hacia el resultado que deseas. El uso efectivo de prompts negativos mejora la calidad y precisión de las imágenes generadas con Stable Diffusion.

¿La IA de Difusión Estable necesita internet?

Difusión Estable se puede ejecutar completamente sin conexión una vez instalada localmente. El único acceso a internet necesario es para descargar inicialmente el código fuente y los archivos del modelo. Después de la configuración, puedes generar imágenes a través de la interfaz web local sin una conexión a internet. Difusión Estable realiza las inferencias en tu GPU local, lo que la hace más privada y segura que los servicios en la nube. Sin embargo, acceder a Difusión Estable a través de páginas web sí requiere acceso constante a internet. Al ejecutarla localmente, puedes usarla en vuelos, en áreas remotas o donde el acceso a internet es limitado. Así que, aunque el acceso web necesita internet, Difusión Estable no requiere conexión en línea cuando se aloja localmente.

Cómo utilizar embeddings Difusión estable AI

Los embeddings permiten a los modelos de Difusión estable generar imágenes que imiten un estilo visual específico. Para utilizar embeddings, primero entrénalos en un conjunto de datos de imágenes que representen el estilo deseado. Coloca el archivo de embedding en la carpeta de embeddings. En tu prompt de texto, añade el nombre del embedding rodeado de corchetes como [:Nombre:] para activarlo. Difusión estable generará imágenes que coincidan con ese estilo. Ajusta el nivel de intensidad para controlar el efecto. Los embeddings son poderosos para obtener resultados consistentes. Con los embeddings adecuados, puedes personalizar la Difusión estable para obras de arte específicas, estéticas particulares y otros estilos visuales.

Preguntas frecuentes

¿Qué son 'Stable difusion' y 'Stable difussion'?

'Stable difusion' y 'Stable difussion' son errores tipográficos de 'Stable Diffusion'. No existen plataformas separadas con estos nombres. 'Stable Diffusion' es el término correcto para la herramienta de generación de arte con IA conocida por transformar texto en imágenes. Estas faltas de ortografía son comunes, pero se refieren a la misma tecnología.

¿Cómo se relaciona Stability Diffusion XL con Stable Diffusion?

Stability Diffusion XL es una versión avanzada de Stable Diffusion, especializada en la creación de imágenes de alta resolución. Mientras que Stable Diffusion se enfoca en arte generado por IA, Stability Diffusion XL mejora esto con mayor detalle y claridad, ideal para proyectos profesionales de alta calidad.

Introducción a Stable Diffusion

Stable Diffusion es una herramienta de generación de imágenes a partir de texto basada en modelos de difusión, desarrollada por el grupo CompVis en la Universidad Ludwig Maximilian de Múnich y Runway ML, con soporte computacional de Stability AI. Puede generar imágenes de alta calidad a partir de descripciones textuales y también realizar inpainting, outpainting y traducción de imagen a imagen guiada por texto. Stable Diffusion ha puesto a disposición su código, modelos preentrenados y licencia, lo que permite a los usuarios ejecutarlo en una sola GPU. Esto la convierte en el primer modelo de generación de imágenes a partir de texto de código abierto que se puede ejecutar localmente en dispositivos de los usuarios.

¿Cómo funciona Stable Diffusion?

Stable Diffusion utiliza una arquitectura de modelo de difusión llamada Modelos de Difusión Latente (LDM). Consta de 3 componentes: un codificador automático variacional (VAE), un U-Net y un codificador de texto opcional. El VAE comprime la imagen desde el espacio de píxeles a un espacio latente de menor dimensión, capturando información semántica más fundamental. Se añade ruido gaussiano iterativamente al latente comprimido durante la difusión hacia adelante. El bloque U-Net (que consiste en una columna vertebral ResNet) deshace el ruido de la difusión hacia adelante para obtener una representación latente. Finalmente, el decodificador VAE genera la imagen final al convertir la representación de nuevo al espacio de píxeles. La descripción del texto se expone a los U-Nets de desruido a través de un mecanismo de atención cruzada para guiar la generación de imágenes.

Datos de Entrenamiento para Stable Diffusion

Stable Diffusion fue entrenado con el conjunto de datos LAION-5B, que contiene pares de imágenes y texto extraídos de Common Crawl. Los datos fueron clasificados por idioma y filtrados en subconjuntos con mayor resolución, menor probabilidad de marcas de agua y mayores puntuaciones estéticas. Las últimas rondas de entrenamiento también dejaron caer el 10% del condicionamiento de texto para mejorar la Guía de Difusión sin Clasificador.

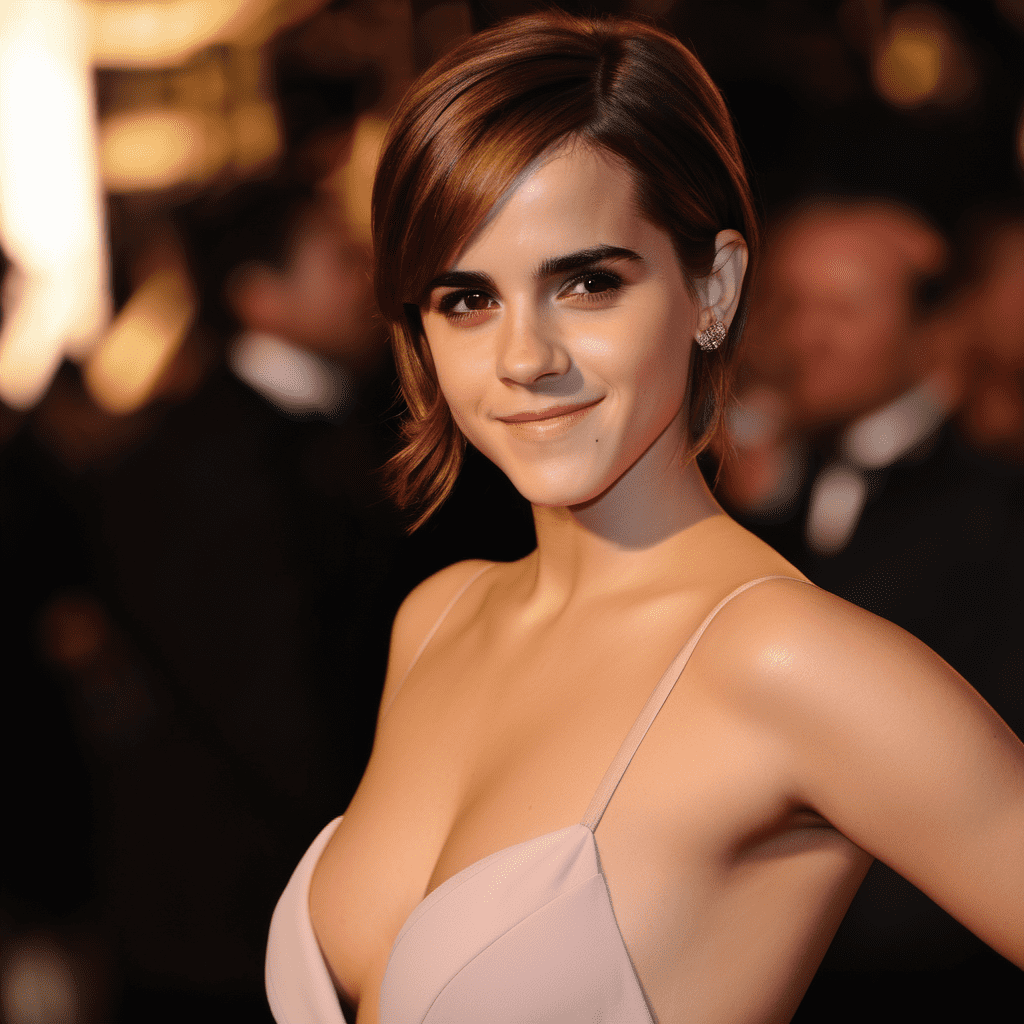

Capacidades de Stable Diffusion

Stable Diffusion puede generar nuevas imágenes desde cero basadas en prompts de texto, redibujar imágenes existentes para incorporar nuevos elementos descritos en texto, y modificar imágenes existentes mediante inpainting y outpainting. También admite el uso de 'ControlNet' para cambiar el estilo y el color de la imagen mientras se preserva la estructura geométrica. También es posible realizar intercambio de rostros. Todo esto proporciona una gran libertad creativa a los usuarios.

Acceso a Stable Diffusion

Los usuarios pueden descargar el código fuente para configurar Stable Diffusion localmente, o acceder a su API a través del sitio web oficial de Stable Diffusion, Dream Studio. Dream Studio ofrece una interfaz sencilla e intuitiva y varias herramientas de configuración. Los usuarios también pueden acceder a la API de Stable Diffusion a través de sitios de terceros como Hugging Face y Civitai, que proporcionan varios modelos de Stable Diffusion para diferentes estilos de imagen.

Limitaciones de Stable Diffusion

Una limitación importante de Stable Diffusion es el sesgo en sus datos de entrenamiento, que provienen predominantemente de páginas web en inglés. Esto conduce a resultados sesgados hacia la cultura occidental. También tiene dificultades para generar extremidades humanas y rostros. Algunos usuarios han informado que Stable Diffusion 2 rinde peor que la serie Stable Diffusion 1 al representar celebridades y estilos artísticos. Sin embargo, los usuarios pueden ampliar las capacidades del modelo mediante el ajuste fino. En resumen, Stable Diffusion es un poderoso y en constante mejora modelo de aprendizaje profundo de código abierto para la generación de imágenes a partir de texto que proporciona una gran libertad creativa a los usuarios. Pero también debemos ser conscientes de los posibles sesgos de los datos de entrenamiento y asumir la responsabilidad del contenido generado al utilizarlo.

,%20(Masterfully%20crafted%20Glow),%20hyper%20details,(delicate%20detailed).png)

%20as%20Harley%20Quinn%20(DC%20Comics).png)

);%20blue%20eyes.png)