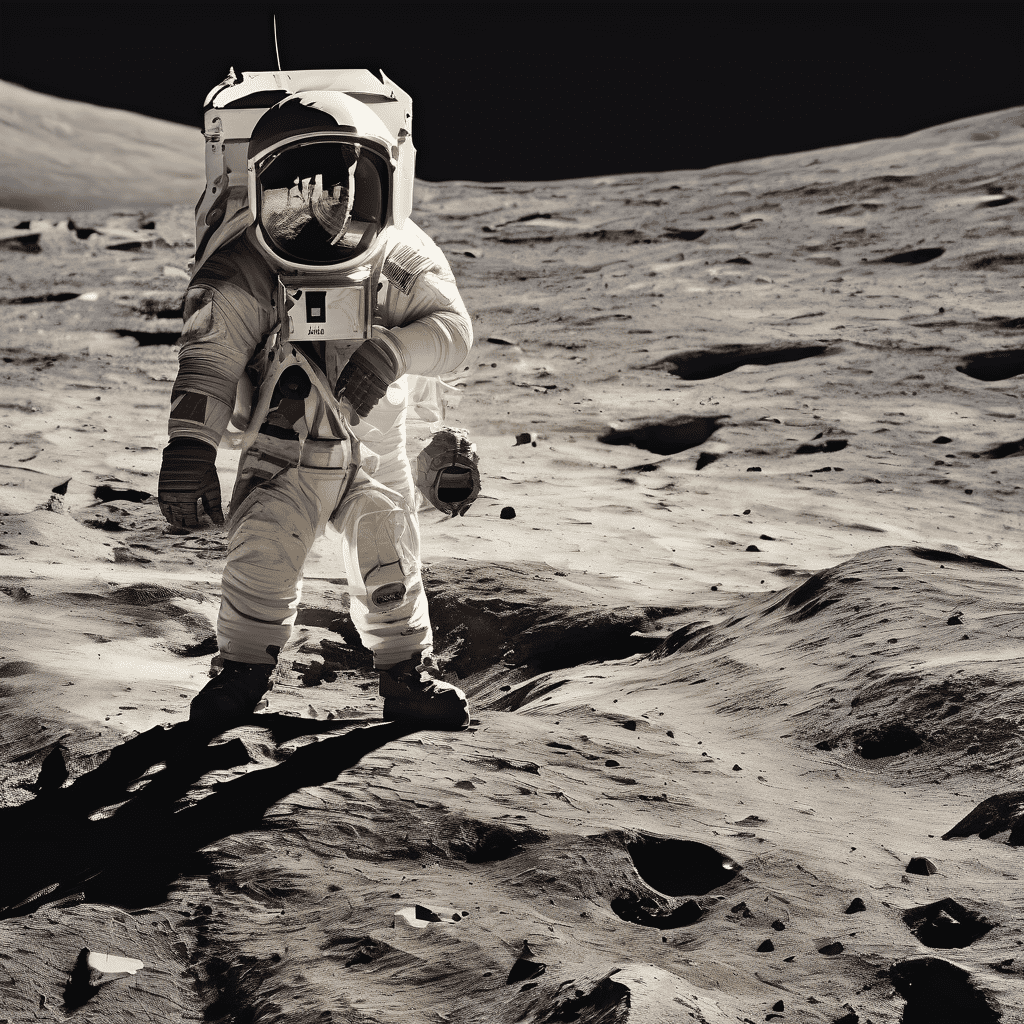

Text zu Bild mit dem AI-Kunstgenerator

AI-Kunst leicht gemacht mit Stable Diffusion Online

Stable Diffusion Online revolutioniert die Erstellung von AI-Kunst und bietet eine benutzerfreundliche Plattform für Anfänger und Experten zugleich. Es ist das ideale Werkzeug für alle, die AI Stable Diffusion erkunden möchten, ohne umfassende technische Kenntnisse zu benötigen. Die Oberfläche ist benutzerfreundlich gestaltet, sodass Nutzer ihre Ideen schnell in ansprechende visuelle Inhalte verwandeln können. Es ist mehr als nur ein AI-Bildgenerator; es verbindet Kreativität und Technologie und macht den künstlerischen Prozess sowohl angenehm als auch zugänglich. Ob Sie zum ersten Mal in die digitale Kunst eintauchen oder ein erfahrener Künstler sind, Stable Diffusion Online lässt Ihre Visionen mühelos Wirklichkeit werden und ist die ideale Lösung für die Erstellung von Stable Diffusion Kunst online.

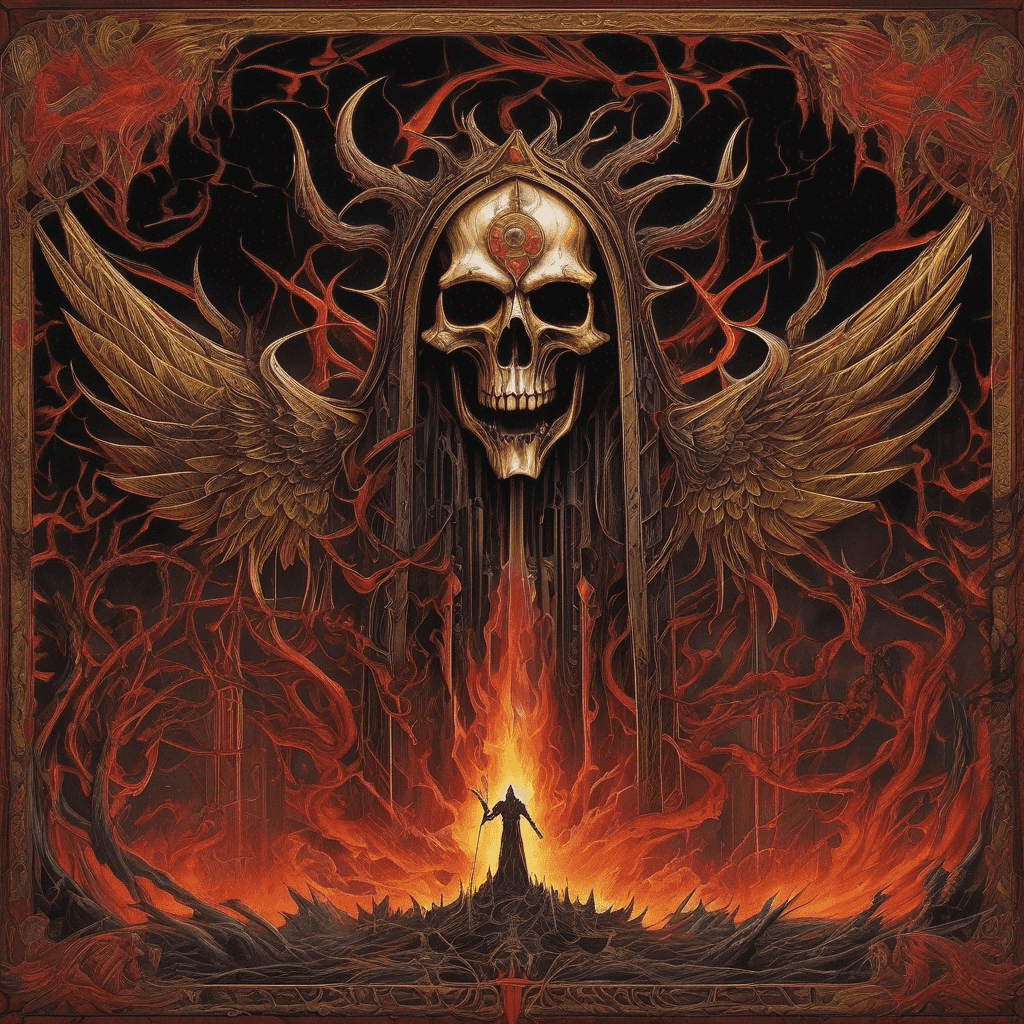

Entfalten Sie Ihr künstlerisches Potenzial mit dem Stable Diffusion AI Image Generator

Der Stable Diffusion AI Image Generator ist ein kraftvolles Tool für Künstler und Designer, das für die Erstellung komplexer, hochwertiger Bilder entwickelt wurde. Dieses Tool ist ideal für alle, die KI in ihren kreativen Prozess integrieren möchten und unvergleichliche Details und Anpassungsmöglichkeiten suchen. Es ist mehr als nur ein KI-Tool für Stable Diffusion; es ist ein Partner in der Kreativität, der detaillierte Landschaften, komplexe Designs und konzeptionelle Kunstwerke mit nur wenigen Klicks zum Leben erweckt. Ob für digitales Marketing oder persönliche Projekte – dieser AI Image Generator macht es einfach, einzigartige, wirkungsvolle Kunstwerke zu erstellen. Der Stable Diffusion AI Image Generator besticht durch seine Fähigkeit, komplexe künstlerische Visionen umzusetzen, und ist ein unentbehrliches Tool für alle, die das Potenzial von AI-Diffusion in ihrer Kunst nutzen möchten.

Hochauflösende KI-Kunst mit Stable Diffusion XL Online

Stable Diffusion XL Online bringt die Erstellung von KI-Kunst auf ein neues Niveau und konzentriert sich auf hochauflösende, detailreiche Bilder. Diese Plattform ist maßgeschneidert für professionelle Projekte und liefert herausragende Qualität für digitale Kunst und Design. Mit Spezialisierung auf ultra-hochauflösende Ergebnisse ist es das ideale Werkzeug zur Erstellung großformatiger Kunstwerke und detaillierter digitaler Werke. Stable Diffusion XL Online ist mehr als nur ein Stable Diffusion Online-Tool; es ist ein Tor zu weitreichenden kreativen Möglichkeiten durch KI. Es zeichnet sich dadurch aus, komplexe Ideen in visuelle Meisterwerke von höchster Qualität zu verwandeln, ideal sowohl für kommerzielle als auch künstlerische Projekte. Begrüßen Sie die Zukunft der hochauflösenden KI-Kunst mit Stable Diffusion XL Online, bei der jedes Detail in beeindruckender Klarheit und Präzision wiedergegeben wird.

Stable Diffusion XL-Modell

Stable Diffusion XL 1.0 (SDXL) ist die neueste Version des KI-Bilderstellungssystems Stable Diffusion, das von Stability AI entwickelt und im Juli 2023 veröffentlicht wurde. SDXL bringt bedeutende Verbesserungen gegenüber früheren Versionen durch sein duales Modellsystem mit 6 Milliarden Parametern, das eine Auflösung von 1024x1024, hochrealistische Bildgenerierung, lesbare Textdarstellungen, vereinfachte Eingaben mit weniger Worten und integrierte voreingestellte Stile ermöglicht. Stable Diffusion XL stellt einen großen Sprung in der Qualität, Flexibilität und im kreativen Potenzial der KI-Bilderstellung im Vergleich zu früheren Stable Diffusion-Versionen dar.

Was ist Stable Diffusion KI

Stable Diffusion ist ein Open-Source-KI-System zur Erstellung realistischer Bilder und zur Bearbeitung vorhandener Bilder. Es nutzt ein Deep-Learning-Modell, das auf Millionen von Bild-Text-Paaren trainiert wurde. Basierend auf einer Texteingabe erzeugt Stable Diffusion Bilder, die der Beschreibung entsprechen. Nutzer können es über Websites wie Stablediffusionai.ai aufrufen oder lokal ausführen. Stable Diffusion stellt einen Durchbruch in der öffentlich zugänglichen KI-Bilderstellung dar. Trotz Einschränkungen wie Datenverzerrung im Training ermöglicht es Künstlern und Kreativen eine bisher unerreichte kreative Freiheit. Bei verantwortungsbewusstem Einsatz bietet Stable Diffusion spannende Möglichkeiten in Kunst, Medien und darüber hinaus.

So nutzen Sie Stable Diffusion AI

Stable Diffusion ist ein KI-Bildgenerator. Um Stable Diffusion AI zu nutzen, gehen Sie auf stablediffusionai.ai. Geben Sie eine Texteingabe ein, die das gewünschte Bild beschreibt. Passen Sie Einstellungen wie Bildgröße und Stil an. Klicken Sie auf „Dream“, um das Bild zu generieren. Wählen Sie das gewünschte Bild aus und laden Sie es herunter oder teilen Sie es. Verfeinern Sie Ihre Eingaben und Einstellungen, um die gewünschten Ergebnisse zu erzielen. Sie können Bilder auch mit den Inpainting- und Outpainting-Funktionen bearbeiten. Stable Diffusion bietet umfangreiche kreative Möglichkeiten, wenn es gezielt eingesetzt wird.

So laden Sie Stable Diffusion herunter

Stable Diffusion ist auf GitHub verfügbar. Um es herunterzuladen, gehen Sie zu github.com/CompVis/stable-diffusion und klicken Sie auf den grünen "Code"-Button. Wählen Sie "Download ZIP", um den Quellcode und die Modelldaten herunterzuladen. Entpacken Sie die ZIP-Datei, nachdem Sie sie heruntergeladen haben. Sie benötigen mindestens 10 GB freien Speicherplatz. Um Stable Diffusion zu verwenden, benötigen Sie außerdem Python sowie eine GPU mit mindestens 4 GB VRAM. Alternativ können Sie Stable Diffusion über Websites wie Stablediffusionai.ai nutzen, ohne es auf Ihrem Rechner zu installieren. Stable Diffusion bietet beispiellosen Zugang zu einem leistungsstarken KI-Bildgenerator. Laden Sie es herunter und lassen Sie Ihrer Kreativität freien Lauf.

Wie installiere ich die Stable Diffusion KI?

Um Stable Diffusion zu installieren, benötigen Sie einen PC mit Windows 10 oder 11, eine GPU mit mindestens 4 GB VRAM und eine Python-Installation. Laden Sie das Stable Diffusion-Code-Repository herunter und entpacken Sie es. Laden Sie die vortrainierte Modell-Checkpoint-Datei und die Konfigurationsdatei herunter und legen Sie sie in die entsprechenden Ordner ab. Führen Sie die Datei webui-user.bat aus, um die Web-Benutzeroberfläche zu starten. Sie können jetzt Bilder erzeugen, indem Sie Texteingabeaufforderungen eingeben. Passen Sie Einstellungen wie Sampling-Schritte und Inferenz-Schritte an. Installieren Sie Erweiterungen wie z.B. Automatic1111 für zusätzliche Funktionen. Mit der richtigen Konfiguration können Sie diesen leistungsstarken KI-Bildgenerator lokal betreiben.

Wie trainiere ich die Stable Diffusion KI?

Um Ihr eigenes Stable Diffusion-Modell zu trainieren, benötigen Sie einen Datensatz mit Bild-Text-Paaren, eine GPU mit ausreichendem VRAM und technische Kenntnisse. Bereiten Sie zunächst Ihre Trainingsdaten vor und bereinigen Sie sie. Ändern Sie dann die Konfigurationsdateien von Stable Diffusion, um auf Ihren Datensatz zu verweisen. Stellen Sie Hyperparameter wie Batchgröße und Lernrate ein. Starten Sie die Trainingsskripte, um den VAE, das UNet und den Text-Encoder separat zu trainieren. Da das Training sehr rechenintensiv ist, sollten Sie bei Bedarf eine Cloud-GPU-Instanz mieten. Überwachen Sie den Trainingsfortschritt. Bewerten Sie nach dem Training die Modellleistung. Nehmen Sie Feinabstimmungen vor, bis Sie zufrieden sind. Mit Zeit, Rechenleistung und Mühe können Sie Stable Diffusion an Ihre spezifischen Bedürfnisse anpassen.

Was ist Lora bei Stable Diffusion?

Lora, kurz für 'Learned Regional Augmentation', ist eine Technik zur Verbesserung von Stable Diffusion-Modellen. Loras sind kleine neuronale Netzwerke, die auf Bilddatensätzen trainiert werden, um das Modell auf bestimmte Details wie Gesichter, Hände oder Kleidung zu spezialisieren. Um eine Lora zu verwenden, laden Sie sie herunter und platzieren Sie sie im richtigen Ordner. Fügen Sie in Ihren Prompts das Schlüsselwort der Lora hinzu, um sie zu aktivieren. Loras bieten mehr Kontrolle über Details, ohne das gesamte Modell neu trainieren zu müssen. Sie ermöglichen die Anpassung von Stable Diffusion zur Generierung von Anime-Charakteren, Porträts, Modellen und mehr. Mit den richtigen Loras können Sie Stable Diffusion auf ein neues Detail- und Anpassungsniveau heben.

Was ist ein negativer Prompt in der Stable Diffusion KI?

In Stable Diffusion ermöglichen negative Prompts Ihnen, Dinge anzugeben, die Sie in einem generierten Bild nicht sehen möchten. Dabei handelt es sich einfach um Wörter oder Phrasen, die dem Modell mitteilen, was vermieden werden soll. Zum Beispiel reduziert das Hinzufügen von "schlecht gezeichnete Bilder, hässlich, zusätzliche Finger" als negativer Prompt die Wahrscheinlichkeit, dass diese unerwünschten Elemente erscheinen. Negative Prompts geben Ihnen mehr Kontrolle über den Bildgenerierungsprozess. Sie sind nützlich, um häufige Fehler wie Verzerrungen oder Artefakte auszuschließen. Die Angabe von negativen Prompts zusammen mit positiven Prompts hilft, das Modell in Richtung Ihres gewünschten Ergebnisses zu lenken. Der effektive Einsatz negativer Prompts verbessert die Qualität und Genauigkeit der mit Stable Diffusion erzeugten Bilder.

Benötigt die Stable Diffusion KI eine Internetverbindung?

Stable Diffusion kann vollständig offline betrieben werden, sobald es lokal installiert ist. Die einzige Internetverbindung, die benötigt wird, ist für den initialen Download des Quellcodes und der Modell-Dateien. Nach der Einrichtung können Sie Bilder über die lokale Web-Oberfläche ohne Internetverbindung generieren. Stable Diffusion führt Inferenzprozesse vollständig auf Ihrer lokalen GPU aus, was es privater und sicherer macht als cloudbasierte Dienste. Der Zugriff auf Stable Diffusion über Websites erfordert jedoch eine ständige Internetverbindung. Wenn Sie es lokal betreiben, umgehen Sie dies und können es auch während Flügen, in abgelegenen Gebieten oder an Orten verwenden, an denen das Internet eingeschränkt ist. Während für den Webzugriff eine Internetverbindung erforderlich ist, benötigt Stable Diffusion selbst bei lokalem Betrieb keine Onlineverbindung.

So nutzen Sie Embeddings Stable Diffusion KI

Embeddings ermöglichen es Stable Diffusion-Modellen, Bilder in einem bestimmten visuellen Stil zu generieren. Um Embeddings zu nutzen, trainieren Sie diese zunächst mit einem Datensatz von Bildern, die den gewünschten Stil repräsentieren. Legen Sie die Embedding-Datei im Embeddings-Ordner ab. Fügen Sie in Ihrem Text-Prompt den Namen des Embeddings in eckigen Klammern wie [:Name:] hinzu, um sie zu aktivieren. Stable Diffusion wird dann Bilder erzeugen, die diesem Stil entsprechen. Passen Sie die Intensität an, um die Wirkung zu steuern. Embeddings sind eine leistungsstarke Methode, um konsistente Ergebnisse zu erzielen. Mit den richtigen Embeddings können Sie Stable Diffusion für bestimmte Kunstwerke, Ästhetiken und andere visuelle Stile anpassen.

Häufig gestellte Fragen

Was sind 'Stable difusion' und 'Stable difussion'?

'Stable difusion' und 'Stable difussion' sind Rechtschreibfehler für 'Stable Diffusion.' Es gibt keine separaten Plattformen mit diesen Namen. 'Stable Diffusion' ist der korrekte Begriff für das KI-gestützte Bildgenerierungstool, das dafür bekannt ist, Texte in Bilder zu verwandeln. Diese Rechtschreibfehler sind häufig, beziehen sich jedoch auf dieselbe Technologie.

Wie steht Stability Diffusion XL im Zusammenhang mit Stable Diffusion?

Stability Diffusion XL ist eine fortschrittliche Version von Stable Diffusion, die auf die Erstellung hochauflösender Bilder spezialisiert ist. Während Stable Diffusion sich auf KI-generierte Kunst konzentriert, verbessert Stability Diffusion XL diese mit größerer Detailgenauigkeit und Klarheit, ideal für hochwertige, professionelle Projekte.

Einführung in Stable Diffusion

Stable Diffusion ist ein Open-Source-Tool zur Text-zu-Bild-Generierung, das auf Diffusionsmodellen basiert und von der CompVis-Gruppe an der Ludwig-Maximilians-Universität München und Runway ML entwickelt wurde, mit Unterstützung durch Rechenressourcen von Stability AI. Es kann qualitativ hochwertige Bilder aus Textbeschreibungen erzeugen und auch Bildrestaurierung, -erweiterung und textgesteuerte Bild-zu-Bild-Übersetzungen durchführen. Stable Diffusion hat seinen Code, vortrainierte Modelle und Lizenzen veröffentlicht, sodass Benutzer es auf einer einzelnen GPU ausführen können. Damit ist es das erste Open-Source-Tiefenmodell zur Text-zu-Bild-Generierung, das lokal auf Benutzergeräten betrieben werden kann.

Wie funktioniert Stable Diffusion?

Stable Diffusion verwendet eine Diffusionsmodellarchitektur namens Latent Diffusion Models (LDM). Es besteht aus drei Komponenten: einem Variational Autoencoder (VAE), einem U-Net, welches aus einem ResNet-Backbone besteht, und einem optionalen Text-Encoder. Der VAE komprimiert das Bild von der Pixel-Ebene in einen kleineren latenten Raum, der grundlegende semantische Informationen erfasst. Während der Vorwärtsdiffusion wird dem komprimierten latenten Raum iterativ Gaußsches Rauschen hinzugefügt. Der U-Net-Block entstört das Ergebnis der Vorwärtsdiffusion rückwärts, um eine latente Repräsentation zu erhalten. Schließlich erzeugt der VAE-Dekoder das endgültige Bild, indem er die Repräsentation zurück in den Pixelraum umwandelt. Die Textbeschreibung wird dem U-Net durch einen Cross-Attention-Mechanismus zur Steuerung der Bildgenerierung zugeführt.

Trainingsdaten für Stable Diffusion

Stable Diffusion wurde auf dem LAION-5B-Datensatz trainiert, der Bild-Text-Paare enthält, die von Common Crawl gesammelt wurden. Die Daten wurden nach Sprache klassifiziert und in Teilmengen mit höherer Auflösung, geringerer Wahrscheinlichkeit von Wasserzeichen und höheren vorhergesagten 'ästhetischen' Bewertungen gefiltert. In den letzten Trainingsrunden wurden auch 10% der Textkonditionierung weggelassen, um die Classifier-Free Diffusion Guidance zu verbessern.

Fähigkeiten von Stable Diffusion

Stable Diffusion kann neue Bilder von Grund auf basierend auf Texteingaben erstellen, bestehende Bilder neu zeichnen, um neue im Text beschriebene Elemente einzubauen, und bestehende Bilder durch Inpainting und Outpainting ändern. Es unterstützt auch die Verwendung von 'ControlNet', um den Bildstil und die Farben zu ändern und gleichzeitig die geometrische Struktur beizubehalten. Auch der Gesichtsaustausch ist möglich. All dies bietet den Benutzern umfassende kreative Freiheit.

Zugriff auf Stable Diffusion

Benutzer können den Quellcode herunterladen, um Stable Diffusion lokal auf ihren Geräten einzurichten, oder über die offizielle Stable Diffusion-Website Dream Studio auf die API zugreifen. Dream Studio bietet eine einfache und intuitive Benutzeroberfläche sowie verschiedene Einstellungstools. Benutzer können auch über Drittanbieter-Websites wie Hugging Face und Civitai auf die Stable Diffusion-API zugreifen, die verschiedene Stable Diffusion-Modelle für unterschiedliche Bildstile bereitstellen.

Einschränkungen von Stable Diffusion

Eine wesentliche Einschränkung von Stable Diffusion ist die Voreingenommenheit in den Trainingsdaten, die überwiegend von englischsprachigen Webseiten stammen. Dies führt zu Ergebnissen, die tendenziell von westlichen kulturellen Einflüssen geprägt sind. Zudem hat Stable Diffusion Schwierigkeiten bei der Darstellung von menschlichen Gliedmaßen und Gesichtern. Einige Benutzer berichteten auch, dass Stable Diffusion 2 schlechter abschneidet als die Stable Diffusion 1-Serie bei der Darstellung von Prominenten und künstlerischen Stilen. Benutzer können die Fähigkeiten des Modells jedoch durch Feinabstimmungen erweitern. Zusammenfassend ist Stable Diffusion ein leistungsstarkes und sich ständig verbesserndes Open-Source-Tiefenmodell zur Text-zu-Bild-Generierung, das den Benutzern umfassende kreative Freiheit bietet. Allerdings sollten wir uns auch der möglichen Voreingenommenheit der Trainingsdaten bewusst sein und Verantwortung für die generierten Inhalte übernehmen.

,%20(Masterfully%20crafted%20Glow),%20hyper%20details,(delicate%20detailed).png)

%20as%20Harley%20Quinn%20(DC%20Comics).png)

);%20blue%20eyes.png)